Fragilité ?

Historiquement, les journaux ont été désireux de supporter ces coûts fixes élevés [en particulier les coûts relatifs à la taille de la rédaction, ndlr] car en contrepartie, ils espéraient des profits. Publier une information en exclusivité pour un journal papier lui assurait, au moins durant une journée, une augmentation de ses ventes et donc de ses revenus, car cette information n’était pas disponible dans l’exemplaire papier des journaux concurrent

. Autrement dit, l’information avait alors une valeur commerciale. Ce n’est plus le cas aujourd’hui. Sur Internet, sitôt publiée, l’information est disponible presque immédiatement sur le site des journaux concurrents. Comment monétiser dès lors la production d’une information originale ? Quelles incitations les médias ont-ils encore à payer pour une rédaction pléthorique alors qu’ils pourraient se contenter d’un petit nombre de journalistes en charge de monitorer le web et de faire du copié-collé, voire de simples algorithmes et de « journalistes robots » ? (p.13)

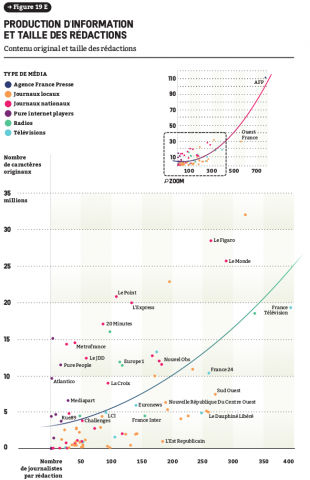

La taille moyenne des rédactions des médias d’information en France diminue de 1 % par an depuis 2013. Or 1 % de journalistes en moins, c’est 1,20 % de moins d’information originale produite. Toutes choses égales par ailleurs, si la diminution de la taille moyenne des rédactions devait continuer au rythme actuel, cela impliquerait qu’en 2020, ce seraient plus de 30 000 articles d’information entièrement originaux de moins qui seraient produits qu’en 2013.Or, au vu des changements actuels, 1 % de baisse par an est une estimation basse de la diminution de la taille des rédactions

. Un journal comme L’Express est passé de plus de 120 cartes de presse en 2013 à 40 aujourd’hui, soit un retour à la situation du journal… en 1965. L’Obs, qui a annoncé en juin 2016 un nouveau plan de départs volontaires, avait déjà vu le nombre de ses cartes de presse diminuer de 50 entre 2014 et 2015. Et c’est sans parler d’I-télé qui en 2016 a perdu plus de la moitié de sa rédaction suite au bras de fer qui a opposé les journalistes à un actionnaire intrusif et peu soucieux de déontologie, Vincent Bolloré pour ne pas le nommer. Certes, l’approche quantitative présente de nombreuses limites mais les tendances actuelles font peser une véritable menace sur l’information originale

. (p. 16-17)

Mise en forme : WeDoData

Citations et réputation

Si l’audience agrégée totale des sites d’information augmente les jours où des événements « importants » surviennent (comme on pouvait s’y attendre), cette augmentation ne profite en moyenne que très faiblement aux médias que l’on pourrait qualifier d’« innovants », c’est-à-dire au news breaker et à ceux qui contribuent à la production d’information originale sur l’événement. Leur part d’audience augmente certes de façon statistiquement significative consécutivement la production de cette information originale, mais la magnitude de cette augmentation est extrêmement faible, voire économiquement insignifiante.

Cela ne signifie pas pour autant que les médias n’ont plus aucune incitation (économique) à produire de l’information originale. Si, au jour le jour, les variations de parts de marché ne viennent que faiblement récompenser les médias les plus innovants, au niveau agrégé, la production de contenu original par un média est fortement corrélée à l’audience moyenne de son site internet. En moyenne sur 2013, augmenter chaque jour d’un article la production d’information originale augmente le nombre moyen de visiteurs uniques quotidiens de 14 000, ce qui est loin d’être insignifiant pour un grand nombre de médias. Autrement dit, la production de contenu original semble entraîner sur le moyen terme un effet de réputation qui se répercute sur les audiences en ligne. C’est cet effet de réputation qui expliquerait pourquoi les médias sont toujours incités à produire une information de qualité

.De plus, il est important de noter que cet effet de réputation ne joue pas seulement « en ligne », mais également « hors ligne ». Au niveau mensuel, la production d’une information originale en ligne est en effet corrélée, pour les journaux papiers, avec les ventes en kiosque

.

Les médias tendent à « oublier » le plus souvent de citer les médias qu’ils copient

D’où l’importance des crédits adéquats. Or, les médias tendent de facto à « oublier » le plus souvent de citer les médias qu’ils copient : ils ne le font que dans 8 % des cas. Même quand l’AFP n’est pas le news breaker, les médias préfèrent souvent faire référence à l’agence plutôt qu’au média qui a originellement sorti l’information. Plus de la moitié des citations sont des références à l’AFP. Et dans la majorité des articles publiés en ligne, on ne trouve pas une seule référence à un média concurrent

. (p.17-19)

La fabrique de l’événement médiatique

Il est frappant de noter à quel point le nombre moyen de nouveaux événements est stable dans le temps, comme si chaque jour le même nombre d’événements se produisait, inlassablement, à l’exception des week-ends (et des vacances) où ceux-ci sont moins nombreux. On aurait pu, au contraire, s’attendre à ce que l’actualité soit variable dans son offre d’événements, certains jours étant plus intenses en événements que d’autres, par le hasard des faits ; d’autres jours faisant la « grève des événements », pour détourner le mot heureux de Jean Baudrillard

. On aurait pu s’attendre à ce que, pour reprendre l’hypothétique annonce imaginée par Gaye Tuchman, les médias nous fassent savoir certains jours que « du fait de circonstances hors de leur contrôle, rien de nouveau ne s’est produit aujourd’hui » et qu’ils ne vont donc rien publier

. Mais non, au rythme de 68 en moyenne, les événements viennent toujours en nombre égal frapper chaque jour à la porte des journalistes. Car l’événement est ici médiatique, construit par le journaliste qui ne peut rendre copie blanche

. (p.39-40)

Une vitesse de propagation extrêmement élevée

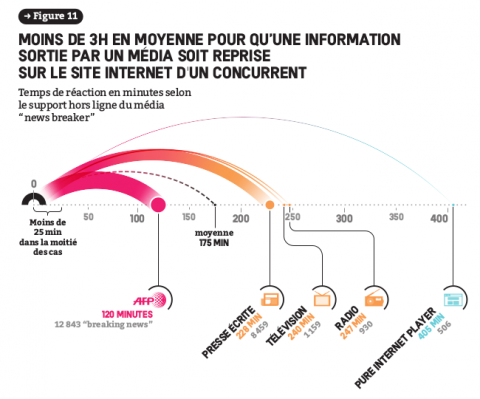

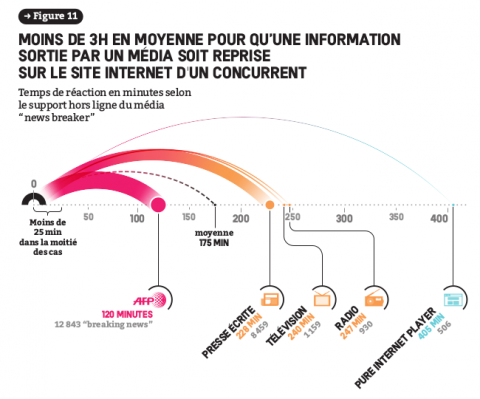

La vitesse de propagation varie en fonction de plusieurs facteurs. Tout d’abord, elle varie en fonction du média news breaker. Nous venons de souligner la reprise automatique de contenus AFP ; à l’autre extrême, le temps de réaction est le plus long quand le news breaker est un pure internet player.

Mise en forme : WeDoData

Il faut en moyenne 405minutes (soit près de 7 heures) pour qu’une information révélée par un pure player soit reprise sur le site internet d’un média concurrent (ou par l’AFP). C’est près de deux fois et demie le temps moyen de réactivité. Comment expliquer cette « lenteur » relative ? Elle provient en partie de l’arbitrage auquel sont confrontés les journalistes entre rapidité d’une part et véracité de l’autre. Car les pure players souffrent en 2013 comme aujourd’hui d’un déficit de réputation par rapport à un certain nombre de médias traditionnels ; ceux-ci sont dès lors davantage incités à vérifier les informations publiées par les pure players plutôt qu’à les reprendre instantanément. Il suffit, parexemple, de penser au très faible nombre de reprises auquel a donné lieu l’interview de Ziad Takieddine dans Mediapart en novembre 2016 sur le financement libyen de la campagne de Nicolas Sarkozy. (p.45-46)

L’importance du copié-collé

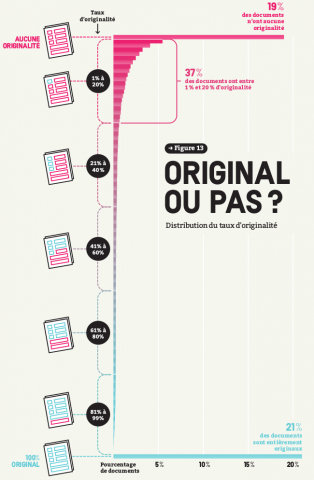

Quelle est l’importance du contenu copié-collé par rapport au contenu original dans la production d’information sur Internet ? D’après nos estimations, le taux moyen d’originalité d’un article en ligne – défini comme la part du contenu original de l’article rapporté à son contenu total – n’est que de 36 %

. Autrement dit, 64 % de ce qui est publié en ligne est du copié-collé pur et simple. De plus, ce taux moyen cache de très fortes disparités : la distribution du taux d’originalité est en fait bimodale, près de 19 % des plus de 850 000 articles classés dans des événements ne présentant aucune originalité, et 21 % d’entre eux étant entièrement originaux.

Plus de la moitié des articles (56 %) présentent moins de 20 % de contenu original. (p.51)

Mise en forme : WeDoDatafn.

Le risque croissant de l’homogénéisation

Doit-on être surpris par de telles estimations ? Probablement pas. D’une part, ce résultat est cohérent avec les principaux résultats de la littérature existante, et en particulier avec les travaux de P. J. Boczkowski, qui a mis en évidence l’homogénéisation de la production d’actualités en ligne en Argentine à partir d’une approche qualitative

. D’autre part et surtout, le copié-collé est la contrepartie de la réactivité. On ne peut pas attendre d’un journaliste qu’il écrive à partir de rien plus de 2 000 caractères en l’espace de cinq minutes.

Doit-on s’en inquiéter ? L’enjeu est double ici. On observe une homogénéisation croissante des contenus ; il est facile de la dénoncer, mais l’on peut également décider d’observer le verre à moitié plein et noter que l’un des corollaires de ce recours à la copie est que davantage d’information est mise à disposition du plus grand nombre gratuitement aujourd’hui

.

Par ailleurs – et c’est ce qui nous semble ici le plus inquiétant –, la combinaison du recours à la copie et de la vitesse de propagation de l’information risque de tuer à terme les incitations des médias à produire une information originale, à faire perdre à l’information originale toute valeur commerciale. Or l’information originale est coûteuse à produire, et la copie mêlée à la réactivité fait de chaque site internet un substitut du site concurrent. Les médias n’arrivent ainsi plus à monétiser cette information si coûteuse à produire. C’est pourquoi il nous a semblé urgent de mettre à plat la réalité de la propagation de l’information en ligne, afin de souligner les difficultés qu’elle fait poser sur le futur de l’information et de nos démocraties. (p.54-55)

Comment monétiser l’information ?

L’importance de la réputation tend d’ailleurs à faire émerger de nouvelles pistes en termes de monétisation de l’information. Le besoin de rentabilité économique à court terme pourrait bien étayer le développement du droit d’auteur ou de droits voisins au domaine des médias. La syndication de contenus commence d’ores et déjà à devenir une source de revenu pour des médias à forte réputation. Quant à la syndication de la diffusion, si elle ne touche pour l’instant que les nouveaux venus en ligne, elle permet tout en contournant la voracité des GAFA, d’expérimenter une nouvelle relation au public, à savoir l’article à la demande dans une offre multiple, ou un choix informationnel adapté à un usage instantané, borné par le revenu ou le temps disponible.

Quelle information souhaitons-nous collectivement et à quel prix ?

Car il nous faut également questionner notre relation de citoyens consommateurs – et pourtant si souvent mauvais payeurs – à l’information. Quelle information souhaitons-nous collectivement et à quel prix ? Secteur d’activité à part dans le tissu économique, média et information tiennent une place essentielle pour assurer la vitalité de nos démocraties. On est prompt à souligner leurs manquements, encore faudrait-il rappeler leur utilité. On ne peut éluder cette question. L’objectif à poursuivre est bien d’assurer une information la plus complète possible des citoyens et de garantir l’expression de la diversité des points de vue. (p.168-169)

* À lire également : l'entretien avec Julia Cagé, Nicolas Hervé, Marie-Luce Viaud.

Titre : L’information à tout prix

Auteurs : Julia Cagé, Nicolas Hervé, Marie-Luce Viaud

Éditeur : Ina Éditions

Date de parution : mars 2017

Prix : 17 €